ما هو ملف robots.txt؟

ملف robots.txt هو ملف نصي يتم وضعه في جذر موقعك الإلكتروني، ويُستخدم لإرشاد محركات البحث مثل Google و Bing حول كيفية فهرسة صفحات موقعك, حيث يمكن استخدامه لتحديد الصفحات التي يجب أن تُفهرس وتظهر في نتائج البحث وكذلك الصفحات التي يجب تجاهلها.

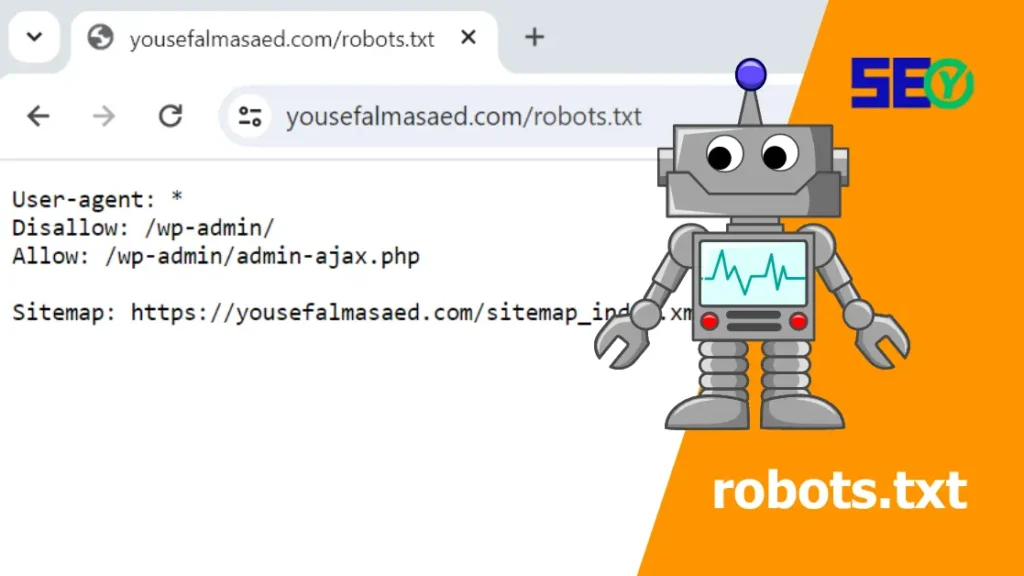

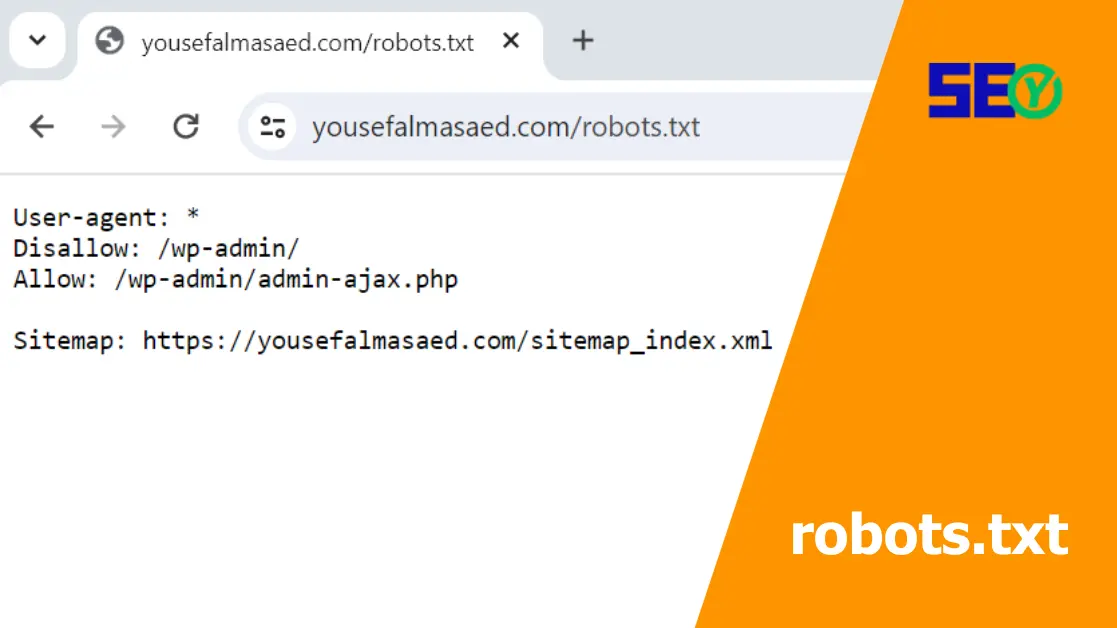

أين يوجد ملف robots.txt؟

يجب وضع ملف robots.txt في الجذر الرئيسي لموقعك على الويب. بمعنى آخر، يجب أن يكون الملف متاحًا على هذا العنوان: “yousef.almasaed.com/robots.txt”، حيث تستبدل “yousef.almasaed.com” بعنوان موقعك الفعلي. هذا يسمح لمحركات البحث بالعثور عليه وقراءته بسهولة لتطبيق التعليمات الموجودة فيه.

مثال لملف robots.txt

بنية ملف robots.txt

ملف robots.txt يتكون من مجموعة من القواعد، كل قاعدة تتكون من مستخدم وكيل (User-agent) ومجموعة من التعليمات:

- User-agent: يحدد الروبوتات التي تنطبق عليها القواعد التالية. يمكن استخدام

*لتطبيق القواعد على جميع الروبوتات. - Disallow: يستخدم لتحديد الصفحات أو الأدلة التي يجب على الروبوتات عدم زيارتها أو فهرستها.

- Allow: يستخدم لتحديد الصفحات أو الأدلة التي يُسمح للروبوتات بزيارتها أو فهرستها، حتى لو كانت موجودة ضمن دليل محظور.

ملاحظة: يمكنك وضع رابط ملف Sitemap.xml داخل ملف robots.txt لمساعدة محركات البحث على العثور على جميع صفحات موقعك بشكل أسهل وأسرع.

أمثلة على تعليمات في ملف robots.txt

User-agent: *

Disallow: /private/

Disallow: /tmp/

Allow: /public/

في هذا المثال:

- User-agent: * يطبق القواعد على جميع الروبوتات.

- Disallow: /private/ يمنع الروبوتات من زيارة أو فهرسة الصفحات ضمن الدليل /private/.

- Disallow: /tmp/ يمنع الروبوتات من زيارة أو فهرسة الصفحات ضمن الدليل /tmp/.

- Allow: /public/ يسمح للروبوتات بزيارة أو فهرسة الصفحات ضمن الدليل /public/، حتى لو كان هذا الدليل ضمن دليل محظور.

إذا كنت تريد تحديد روبوتات معينة من السماح أو المنع شاهد المثال التالي:-

User-agent: Googlebot

Disallow: /private/

في هذا المثال:

- تطبق التعليمات والتوجيهات فقط على الروبوت Googlebot

- المثال يمنع روبوت جوجل بوت من فهرسة الصفحات ضمن الدليل /private/

علاقة ملف robots.txt في ميزانة الزحف

ميزانية الزحف (Crawl Budget) هي مصطلح يستخدم لوصف عدد الصفحات التي يمكن لمحرك البحث زيارتها وفهرستها على موقع ويب في فترة زمنية معينة. ملف robots.txt له دور مهم في إدارة ميزانية الزحف لموقع الويب، وذلك من خلال توجيه سلوك الروبوتات عند زيارة الموقع.

تأثير ملف robots.txt على ميزانية الزحف:

- تقليل الزحف غير الضروري: من خلال استخدام تعليمات

Disallowفي ملفrobots.txt، يمكن لأصحاب المواقع منع الروبوتات من زيارة صفحات معينة لا تحتاج إلى فهرسة. هذا يساعد في توفير موارد الزحف للصفحات الأكثر أهمية. - توجيه الزحف نحو المحتوى الهام: عن طريق السماح للروبوتات بزيارة الصفحات الأساسية والمهمة فقط، يمكن تحسين استخدام ميزانية الزحف وضمان فهرسة المحتوى الضروري بشكل أسرع.

- منع زيارة المحتوى المكرر: يمكن استخدام ملف

robots.txtلمنع الروبوتات من زيارة الصفحات التي تحتوي على محتوى مكرر، مما يساعد في تجنب إهدار ميزانية الزحف على صفحات لا تضيف قيمة لمحركات البحث. - التحكم في معدل الزحف: بعض محركات البحث تسمح باستخدام تعليمات خاصة في ملف

robots.txtللتحكم في معدل زحف الروبوتات إلى الموقع، مما يساعد في تجنب الضغط الزائد على الخادم.

نصائح عند كتابة ملف robots.txt

1. اجعل ملف robots.txt قصيرًا وبسيطًا.

2. استخدم قواعد واضحة ومباشرة.

3. اختبر ملف robots.txt باستخدام أداة اختبار ملف robots.txt في Google Search Console.

4. تأكد من أن ملف robots.txt متاح على موقعك الإلكتروني.

5. راجع ملف robots.txt بانتظام وتأكد من أنه محدث.

إليك بعض النصائح الإضافية:

- استخدم تعليقات في ملف robots.txt لشرح قواعدك.

- استخدم ملف robots.txt لمنع محركات البحث من الزحف إلى صفحات غير ضرورية على موقعك.

- استخدم ملف robots.txt لمنع محركات البحث من فهرسة صفحات تحتوي على معلومات حساسة.

- استخدم ملف Sitemap.xml لإخبار محركات البحث بالصفحات الموجودة على موقعك الإلكتروني.

ملاحظة:

- لا يمنع ملف robots.txt محركات البحث من الوصول إلى صفحات موقعك.

- يمكن لمحركات البحث تجاهل ملف robots.txt إذا كان غير مُنشأ بشكل صحيح.